Après avoir étudié les modèles scientifiques dans une perspective historique et plutôt axée sur la physique, intéressons-nous à ceux-ci en économie et en sociologie. Selon l’économiste Bernard Walliser, relativement aux sciences de la nature, « Les modèles pénètrent bien moins les sciences humaines et sociales, ils y apparaissent comme des îlots isolés au sein d’un savoir plus vaste. Ils ne se distinguent que difficilement des théories, sinon par leur aspect résolument formalisé et idéalisé. Ils interviennent dans des champs où l’on dispose de données statistiques nombreuses sur longue période (modèles de l’éducation en sociologie). […] L’économie (avec la linguistique et la démographie) fait figure d’exception dans les sciences sociales en usant des modèles de façon massive1. »

Si les modèles sont davantage présents en économie qu’en sociologie où les théorisations sont plus conceptuelles2, il me paraît intéressant d’envisager simultanément ces deux disciplines pour trois raisons : premièrement, l’économie et la sociologie emploient des outils formels similaires ; deuxièmement, leurs types de modélisation manifestent deux orientations méthodologiques (individualisme/holisme) que nous avons déjà abordées et que nous allons pouvoir approfondir ; troisièmement, après avoir vu la centralité des modèles en sciences de la nature, constater leur emploi en sciences sociales permet de se demander dans quelle mesure ils sont d’ordre scientifique.

Dans cette optique, nous distinguerons d’abord deux grands types de formalismes, puis nous aborderons la question des paramètres théoriques. Nous interrogerons ensuite la scientificité des modèles, notamment en soulignant un certain nombre de controverses existant en philosophie des sciences. Cet article procurant l’occasion de dégager une synthèse conceptuelle des modélisations en sciences (pas seulement sociales), une liste des fonctions des modèles, résumant l’inventaire dressé par Franck Varenne3, est fournie en annexe.

Deux grands types de formalismes

Distinguons deux grands types de formalismes pour les modélisations en économie et en sociologie : le premier et le plus répandu s’appuie sur les mathématiques, plus particulièrement sur l’algèbre, sur le calcul différentiel et sur les statistiques. Il permet de mettre en évidence des liens ou des différences entre variables (ou facteurs) ainsi que de décrire leurs évolutions4. Le second se fonde sur les algorithmes, notamment ceux utilisés en informatique qui décrivent, entre autres, l’évolution de processus. Dans l’ensemble, les techniques de modélisation bénéficient des progrès informatiques qui facilitent l’exécution de calculs complexes ainsi que la simulation de phénomènes individuels et sociaux.

Les formalismes mathématiques

Les mathématiques ont commencé à être utilisées pour élaborer des modèles autour des années 1920-19405. Jusqu’alors, elles servaient principalement à formuler des théories et des lois dont les chercheurs étaient en quête : nous avons vu l’emploi de statistiques au début du XXe siècle chez Durkheim dans son étude du suicide ; nous pouvons mentionner également les travaux de Francis Galton et de Karl Pearson (fin XIXe– début XXe siècle) qui ont contribué au développement des méthodes statistiques. Galton a notamment baptisé la « régression linéaire ».

Il est intéressant de noter la concomitance entre l’emploi des mathématiques dans des modélisations et le développement du terme modèle qui a surgi « simultanément, en 1936-1937, chez des économistes et des statisticiens, très souvent de formation physicienne, comme Jan Tinbergen, Eugène Slutsky, George et Edouard Guillaume, Abraham Wald, Jean Ullmo, Jacob Marschak, Trygve Haavelmo, Jerzy Neyman6 ».

La discipline de l’économétrie, née en 1930 avec la création de la Société d’économétrie par Irving Fisher et Ragnar Frisch, participe activement de la création de modèles utilisant des outils statistiques comme la régression linéaire, les modèles à décalage temporel, l’analyse de séries temporelles, etc. Par exemple, en microéconomie, on peut exprimer la relation entre la dépense de logement D d’un ménage et son revenu R sous la forme d’une « relation affine (D = D0 + aR) où D0 est la dépense minimale indépendante du revenu et a la fraction du revenu consacrée au logement7. » Dans ce modèle de régression linéaire simple, D est la variable à expliquer et R la variable explicative.

Un modèle économique bien plus élaboré, cette fois en macroéconomie, est celui de la croissance économique de Robert Solow (1956) qui comprend cinq équations :

- une fonction de production ;

- une équation comptable sur le PIB ;

- une équation d’épargne ;

- une équation d’évolution du capital qui est une équation différentielle ;

- une équation d’évolution de la force de travail.

En sociologie, les modèles apparaissent dans les années 1950, en particulier dans les investigations au sujet de la mobilité sociale8 (Bendix et Lipset, Dahrendorf). À ce sujet et à titre d’exemple, rappelons la conceptualisation de l’ « espace social » de Pierre Bourdieu qui s’appuie sur la notion de « capital ». Dans La Distinction (1979), il fournit un « modèle simplifié de cet espace à partir des connaissances acquises au cours des recherches antérieures et sur la base d’un ensemble de données prélevées dans différentes enquêtes9 ». Pour dresser ce panorama, il met en œuvre plusieurs analyses des correspondances, méthodes de statistique exploratoire permettant d’étudier les liaisons entre plusieurs variables.

Globalement, les modèles mathématiques mettent en relief des liens ou des différences entre des variables quantitatives (prix, capital, âge…) et/ou entre des variables qualitatives (préférence, habitude, catégorie sociale…). Les variables, ou facteurs, permettent de caractériser des ensembles de comportements individuels et des ensembles d’individus. Les relations entre variables sont étayées grâce à des techniques statistiques10.

Les formalismes algorithmiques

Les formalismes algorithmiques permettent de modéliser, le plus souvent de manière informatique, des dynamiques, des processus décomposés en une succession d’étapes ou d’opérations qui, en économie et en sociologie, sont fréquemment des prises de décision, des actions individuelles et des interactions. Ils incluent en particulier deux approches basées sur l’individualisme méthodologique : les modèles générateurs de Raymond Boudon11 (intéressants pour leur aspect novateur en France dans les années 1970) et les modèles multi-agents12 qui se développent depuis le début des années 1980.

Dans l’Inégalité des chances (1973), Raymond Boudon propose une approche davantage complémentaire que concurrente de celle de Pierre Bourdieu et Jean-Claude Passeron concernant les inégalités scolaires et la mobilité sociale. Critiquant les « théories factorielles13 » ainsi que l’insistance sur l’héritage culturel, il développe à propos de l’enseignement une modélisation des orientations successives (fin du primaire, fin du secondaire…) de cohortes d’étudiants. Les orientations sont appelées « champs de décision » et elles sont ici davantage « fonction de la position sociale » que du capital culturel, position sociale qui influe sur les choix des acteurs à chaque prise de décision : « l’action de la position sociale est, non pas unique, mais répétitive. Elle engendre des effets multiplicatifs ou, plus exactement, exponentiels14. »

L’idée de fond, présente également dans les modèles multi-agents, est que les modèles décrivant des comportements individuels permettent d’appréhender l’émergence de phénomènes. Boudon évoque de façon générale des « mécanismes générateurs », et dans le cas de l’enseignement des effets multiplicatifs qui, selon lui, expliquent la formation d’inégalités scolaires15. Les modèles multi-agents exploitent davantage les capacités informatiques, l’approche de Boudon utilisant simplement des calculs de probabilités basés sur une liste d’axiomes. Ils sont associés à des simulations.

L’un des premiers modèles multi-agents, et sans doute le plus connu, est le modèle de ségrégation de Thomas Schelling (1971) qui met en évidence des effets non intentionnels découlant d’actions non coordonnées d’un ensemble d’individus : « des « agents » de deux couleurs différentes, représentant des ménages, sont localisés sur une grille (un damier dans le modèle de référence). Ils ne choisissent de changer de localisation que si leurs semblables deviennent significativement minoritaires dans leur « voisinage ». Dans le modèle initial, la configuration homogène où alternent des voisins de couleur différente (comme pour les couleurs des cases du damier) est une configuration localement stable, mais elle devient hautement instable dès qu’elle est perturbée. Le système converge alors vers une configuration « ségréguée » où les agents de même couleur se regroupent en agrégats16. »

Formalisme, holisme et individualisme

Si les formalismes algorithmiques comprennent une part de méthodologie individualiste, ils peuvent inclure des formalismes mathématiques et apparaissent complémentaires de ceux-ci. En particulier, les formalismes mathématiques permettent d’estimer des variables et facteurs qui peuvent constituer des paramètres en entrée ou en sortie des modèles algorithmiques, par exemple des normes influençant le comportement des agents ou dont l’émergence est observée via l’étude d’actions collectives17. Dans la modélisation du système scolaire par Boudon, l’héritage culturel constitue un paramètre en entrée.

Par ailleurs, les formalismes mathématiques peuvent être employés pour décrire des comportements individuels, à l’exemple des modèles à seuil du sociologue américain de l’économie Mark Granovetter18. Celui-ci illustre ce type modèle avec le phénomène de participation à une émeute : imaginons 100 personnes assemblées sur une place et attribuons à chacune un seuil de participation à l’émeute (une personne participe à l’émeute si un seuil de N participants a déjà été atteint) : seuil de 0 à la première personne, de 1 à la seconde, …, de 99 à la centième. Avec cette « distribution » de seuils, la première personne déclenche l’émeute, la seconde la suit, puis la troisième, etc. Et les 100 personnes finissent par participer à l’émeute. En complément de cette notion de distribution de seuil, Granovetter a formulé une équation différentielle pour prédire l’évolution du comportement de la foule et l’atteinte potentielle d’un équilibre comme la participation de l’intégralité des personnes assemblées.

Envisager les modèles en fonction de leur formalisme (mathématique/algorithmique) permet d’articuler holisme et individualisme et d’appréhender la complémentarité des approches : les individus et les groupes, dans les modélisations algorithmiques, prennent en compte des paramètres (variables, facteurs) de type holiste et en produisent également en sortie, des paramètres qui peuvent être mis en relation via des formalismes exclusivement mathématiques.

Formalisme et causalité

Qu’est-ce qu’une cause sociale ? Une force sociale ? un idéaltype ? un(e) variable/facteur employé(e) dans les formalismes mathématiques, notamment un groupe ou une catégorie sociale ? un individu ? un motif ou une raison d’action ? Ces questions, récurrentes en épistémologie des sciences sociales depuis Durkheim et Weber, autrement dit depuis l’aube de ces disciplines académiques, continuent de susciter de vives controverses19, en particulier en France où les présupposés de l’économie politique sont régulièrement critiqués20 au sein des sciences sociales.

De la même manière que je soulignais précédemment la complémentarité des types formalismes, ainsi que celle du holisme et de l’individualisme, je ne privilégie pas un type de cause : des « forces », comme l’égoïsme et l’anomie évoqués par Durkheim au sujet du suicide, peuvent être considérées comme des facteurs macroscopiques associés à un contexte historique et culturel qui, combiné à un contexte biologique, contribue à l’émergence de conditions psychologiques plus ou moins susceptibles d’aboutir à des suicides. Chacun des éléments contextuels (d’ordre culturel, psychologique, biologique…) peut constituer une cause. Même un groupe social, dans la mesure où il est envisagé en tant que notion unificatrice ou lien social par les acteurs, peut être considéré comme une cause sociale.

N’existe-t-il pas une tendance en sciences sociales à restreindre les causes à un ensemble limité d’entités ? Cette tendance21 apparaît aussi bien chez les promoteurs d’une forme d’individualisme méthodologique, insistant souvent sur les aspects biologiques et les biais psychologiques, que chez les défenseurs d’une forme de holisme, soulignant les aspects culturels. Elle peut également s’appréhender de façon politique et morale en distinguant d’une part, les adhérents à l’économie de marché, au capitalisme et au néolibéralisme et, d’autre part, les opposants. Aussi approximative voire réductrice que puisse être cette distinction22, elle signale une fracture des sciences sociales, miroir de fractures politiques.

Les paramètres théoriques

Demeurons autant que faire se peut sur un terrain épistémologique. Qu’elles étayent ou non une pensée critique, les modélisations en sciences sociales s’appuient non seulement sur des formalismes mais aussi sur des paramètres théoriques.

Principes, axiomes

Dans ses Essais sur la théorie de la science, Max Weber indique que « la méthode scientifique de traiter les jugements de valeur ne saurait pas seulement se borner à comprendre [verstehen] et à faire revivre […] les buts voulus et les idéaux qui leur servent de fondements, elle se propose de nous apprendre également à porter un jugement « critique » sur eux. […] En se fixant ce but, elle peut aider l’homme de volonté à prendre conscience lui-même à la fois des axiomes ultimes qui forment la base du contenu de son vouloir et des étalons de valeur […] dont il part inconsciemment ou bien dont il devrait partir pour être conséquent23. »

Cette préconisation, particulièrement intéressante sur le plan épistémologique, a-t-elle été suivie ? Si les formalismes imposent d’expliciter un certain nombre de paramètres24, on peut s’interroger aussi bien en économie qu’en sociologie sur la pleine adoption d’une telle orientation méthodologique. Comme le note Mark Granovetter dans Société et économie, « Le plus souvent informulées, les hypothèses nulles se dissimulent sous la surface de la plupart des descriptions de l’économie issues des sciences sociales : j’entends par là toute supposition de base sous-jacente à l’interprétation des comportements humains et de l’organisation sociale — point de départ conceptuel des chercheurs qui s’efforcent de comprendre un ensemble quelconque de phénomènes. Ces soubassements de tant de formulations rhétoriques des sciences sociales ont un puissant impact psychologique sur qui est persuadé par tel ou tel argument (comme McCloskey l’a si éloquemment souligné en 1983)25. »

Si j’ai utilisé le terme d’hypothèse jusqu’à présent26, en particulier dans la première version de la distinction science/éthique, je préfère dorénavant le réserver, comme le stipule la définition, pour des hypothèses qui seront effectivement testées. Or les principes moraux implicites dans les théorisations sociales ne sont justement pas soumis directement à expérimentation comme peuvent l’être les interactions fondamentales en physique, et même s’ils sont explicites, on peut douter de leur validation au travers d’expériences réalisées dans un contexte social donné, contexte auquel ils sont associés et dont la stabilité historique peut s’avérer éphémère.

Nous nous sommes déjà interrogés plus particulièrement sur les principes sociologiques en réfléchissant aux conceptualisations de Durkheim ainsi qu’à celles de Bourdieu qui a fondé ses analyses sur un principe de luttes structurelles, sur des formes de dominations limitant la capacité critique des acteurs. C’est en remettant en question la position surplombante des sociologues critiques27 que Luc Boltanski et Laurent Thévenot, dans De la justification (1991), ont élaboré un « modèle de la cité » fondé sur des axiomes (ou principes moraux) explicites. Dans le prochain article, nous nous demanderons notamment dans quelle mesure le concept de « modèle de cité » correspond à un modèle sociologique.

En économie, nous avons abordé la problématique de l’existence d’un « homo economicus » lié à un ensemble de paramètres théoriques décrivant sa plus ou moins grande rationalité. Associée à une rationalité induisant davantage de coopération, la théorie des jeux, s’est développée à partir de la fin de la Seconde Guerre mondiale – le dilemme du prisonnier est l’un des plus fameux exemples de jeu. Elle « s’est imposée comme un cadre ontologique général des rapports stratégiques entre acteurs de types quelconques. Elle est rapidement apparue comme le prototype de la modélisation en sciences sociales et a fait école dans d’autres disciplines28. » En tant que « cadre ontologique », la théorie des jeux agrège un ensemble de paramètres théoriques entrant dans la construction de modèles.

Idéalisations, catégories

Les idéalisations ont été évoquées avec l’approche de Nancy Cartwright. Nous avons distingué les idéalisations aristotéliciennes (ou abstractions) des idéalisations galiléennes, qui opèrent des déformations volontaires de la réalité. Les abstractions et les idéalisations galiléennes interviennent dans les formalismes mathématiques et algorithmiques.

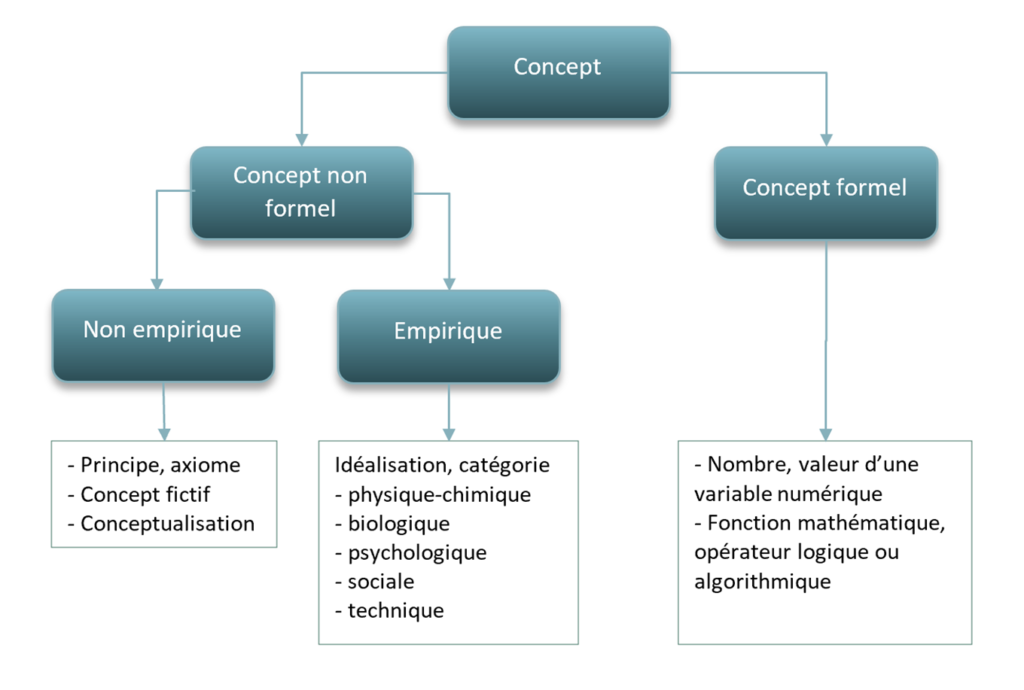

Réfléchissant à propos des modélisations en économie, notamment celle de Robert Lucas (1981), Cartwright a souligné l’emploi d’ « idéalisations non galiléennes » : « la plupart des concepts employés dans ces modèles sont hautement concrets et empiriques29. » De plus, « la théorie présupposée est très maigre. […] Nous avons une poignée de principes très généraux que nous utilisons de façon non controversée en économie, tel que le principe de la théorie de l’utilité30. » Laissons de côté l’idée que la théorie de l’utilité soit non controversée, car ce n’est clairement pas le cas du point de vue sociologique ; ce qui m’intéresse ici, c’est le concept d’idéalisation non galiléenne qui me semble inclure deux types de notions distinctes : d’une part les principes ou axiomes, non empiriques, d’autre part les catégories et idéalisations empiriques d’ordre physique, chimique, biologique, psychologique, social ou technique.

Les idéalisations, plus génériques que les catégories qui correspondent aux variables/facteurs d’un formalisme, regroupent ici les abstractions, les idéalisations galiléennes et non galiléennes. Elles désignent par exemple : en physique, un atome, une couleur, une force ou une énergie, plus largement une unité de mesure (la trajectoire d’un objet étant formelle) ; en biologie, un type de cellule, un composé organique, une interaction ; sur le plan social, une institution, un groupe, une catégorie sociale, un type d’événement, etc.

Fictions et conceptualisations

Également avec l’approche de Cartwright, nous avons mentionné les fictions sous trois formes : les modèles eux-mêmes, les distributions de probabilité en physique statistique, et les fables. La notion de fiction, malgré son intérêt heuristique, m’apparaît bien trop vague et littéraire pour clarifier les conceptualisations scientifiques. De plus, le terme fiction s’oppose dans le langage courant à celui de réalité. Or les réalités de la Terre et de ses environs sont en grande partie façonnées par les êtres humains, notamment sur les plans psychologique et social. Une opposition stricte fiction/réalité n’a donc pas de sens en sciences humaines. Les modélisations et les théorisations permettent progressivement de clarifier les fictions en les décomposant en des formalismes et des paramètres théoriques.

Les principes, les axiomes, les idéalisations et les catégories constituent des conceptualisations, terme générique pouvant caractériser un certain nombre de notions en sociologie comme le fait remarquer Jean-Michel Chapoulie : « Nul ne discute l’importance en sciences sociales de la conceptualisation, mais ce que désigne ce terme et ses dérivés, « conceptualisation », « schème conceptuel », n’est pas précisément défini. Le Trésor de la langue française propose la définition suivante du premier de ces termes : « représentation mentale abstraite et générale, objective, stable, munie d’un support verbal31 ». Par exemple, l’habitus chez Bourdieu ou l’ « institution totale » chez Erving Goffman sont des conceptualisations sociales. Dans le cadre d’un examen des modélisations, en limitant les paramètres théoriques à des principes/axiomes et à des idéalisations/catégories, je m’efforce de clarifier tout en étant conscient, d’une part, de la présence de conceptualisations dans les principes théoriques et, d’autre part, de leur contribution à la clarification, notamment grâce leur intérêt heuristique.

Limites de scientificité des modèles

Mise en valeur de l’action

Les modélisations peuvent être considérées (par exemple, pour les tenants de la conception sémantique des théories) comme les formalisations les plus exactes dont nous disposons. Mais elles constituent au mieux une approximation de la réalité, si ce n’est une fiction pour une philosophe pragmatique comme Nancy Cartwright. Et l’on peut citer le célèbre aphorisme du statisticien George Box : « tous les modèles sont faux, mais certains sont utiles. » Réfléchir sur les modèles et les mettre au premier plan, je l’ai déjà souligné, revient à prendre un certain recul conceptuel par rapport aux théories qui sont de nature globale et qui, en sciences sociales, plus spécialement en sociologie (théories de Parsons, Bourdieu, Boltanski…), ne parviennent pas à susciter, malgré les éclairages qu’elles apportent, l’unanimité de la communauté scientifique.

La prise de recul par rapport aux théories s’est effectuée, dans la seconde moitié du XXe siècle, en parallèle d’un rapprochement de la réalité via la promotion de l’intervention humaine. Suivant un courant pragmatique répandu en sciences de nos jours, de la physique à la sociologie, il s’agit moins de s’assurer de la vérité de théorisations que de concevoir clairement les conditions dans lesquelles nous agissons (expérimentation à visée théorique, projet politico-économique, etc.). Cette mise en valeur de l’action accompagne les exercices critiques consistant à déconstruire des concepts traditionnels et à questionner les orientations politico-économiques. Nous avons observé plus particulièrement ces tendances avec Michel Foucault, Nancy Cartwright, Ian Hacking, et Bruno Latour, et nous poursuivrons avec Luc Boltanski dans le prochain article.

Pour qu’une action soit couronnée de succès, pour qu’un objectif soit atteint ou pour que l’on comprenne pourquoi il ne l’a pas été, il convient de savoir comment faire. C’est là qu’intervient plus spécialement la problématique de la causalité. Si les modèles, quel que soit leur formalisme, permettent de dégager des causes, celles-ci demeurent souvent approximatives, partielles et hypothétiques. Dans quelle mesure peut-on dire que des causes ont été identifiées ? Dans quelle mesure un modèle est-il valide ? Ou encore, quel est le degré de scientificité des modèles ?

Inventaire et stabilité des causes

S’il convient de distinguer la question de la causalité de celle de la validité, ou corroboration, car des modélisations sont à vocation prédictive quand d’autres ont pour objectif de décrire, il ne me semble pas possible de corroborer une loi ou un modèle, aussi descriptifs soient-ils, sans la notion de causalité car toute expérimentation se déroule dans un certain contexte qui décrit un ensemble de causes concernant le phénomène étudié. Et, en dehors des sciences formelles, concevoir sans expérimenter, c’est se situer dans un ciel platonicien.

Connaissance et causalité sont intriquées : tout concept non formel empirique peut constituer une cause suivant le contexte dans lequel il est employé. Par exemple, l’oxygène est une des causes de la combustion ; en laboratoire, le microscope peut être une des causes de la perception ; une jambe n’est pas vitale, mais elle est une des causes de la marche, au même titre que le cœur, le cerveau ou le motif psychologique qui nous fait nous déplacer, ce motif pouvant être en tout ou partie d’origine sociale (par exemple, aller voter, de façon plus générale respecter une norme, aller à un rendez-vous, etc.). De plus, certaines combinaisons de concepts non formels et formels, en particulier les lois, peuvent aussi être considérées comme des causes dans la mesure où elles explicitent des limites de l’évolution d’un phénomène ou d’un système donné. J’attribue donc à la notion de cause une acception large qui n’exclut aucune approche existante en philosophie des sciences32 ni aucune méthodologie.

L’identification de causes s’inscrit dans une perspective qui n’induit pas nécessairement une sorte d’ « instrumentalité » ou d’« utilitarisme » dans la mesure où l’établissement de connaissances nécessite la manipulation et l’observation de causes. Une des problématiques principales en sciences concerne, davantage que la possibilité de déterminer « une cause nécessaire et suffisante », la possibilité de préciser un contexte ou ensemble de causes dans lequel se produit un phénomène décrit par des lois et/ou des modèles, autrement dit d’identifier de la façon la plus exhaustive possible des causes dont font partie les paramètres théoriques empiriques. C’est ce que mettent en évidence les controverses concernant les méthodes statistiques33 : les facteurs ou variables ont-ils été identifiés de façon exhaustive ? Sont-ils tous observables ? Sont-ils indépendants ? Existe-t-il de possibles facteurs de confusion, c’est-à-dire des facteurs communs et/ou antécédents aux causes identifiées ? Les inférences d’une étude statistique peuvent-elles être appliquées à un autre contexte que celui de l’étude ?

En sciences sociales, l’inventaire exhaustif des causes s’avère souvent délicat voire impossible. De plus, la définition de ce qu’est une cause sociale, comme nous l’avons vu plus haut, est sujette à controverses. Notons qu’un concept non formel etnon empirique, par exemple un concept de maison à l’état de projet ou un concept de héros mythique, constitue une cause potentielle dans la mesure où il oriente l’action des acteurs, que ceux-ci en aient conscience ou non. Cela participe à la conflictualité et à la complexité de la définition de la réalité, en particulier au travers des débats politiques concernant les projets de loi et les projets de société, de la spécification des catégories sociales des instituts de statistique ou de sondage, de la qualification de groupes et de comportements sociaux, etc.

Quelques exemples : 1) les définitions des principes républicains (liberté, égalité, fraternité) sont l’objet d’infinies dialectiques philosophiques. 2) La nomenclature INSEE des catégories socioprofessionnelles a été révisée en 2020, notamment pour prendre en compte « des transformations concernant le niveau détaillé des professions : la diffusion des technologies numériques ; le développement des activités liées à la transition écologique ; la convergence de métiers exercés par les agents publics et les salariés du privé ». 3) Devant la diversification des structures familiales, la catégorie marketing « ménagère de plus de 50 ans » a cédé la place à celle de « responsable des achats ». 4) Si le concept de race est non empirique, les comportements associés, en particulier les discriminations, sont empiriques.

La part imaginaire des concepts psychologiques et sociaux, liée à la possibilité humaine de créer et d’innover, particulièrement développée et stimulée depuis deux siècles, interroge la stabilité des paramètres théoriques, que l’évolution de ceux-ci soit d’ordre moral, politique ou technologique. Aux exemples précédents, on peut ajouter bien entendu les innovations informatiques (matériel, réseau, applications) qui participent de reconfigurations sociales considérables. La stabilité des paramètres théoriques est aussi questionnée par les crises environnementales et sanitaires qui favorisent des modifications sensibles de comportements, notamment sur le plan économique. Or l’évolution des paramètres théoriques, en particulier celle des principes, peut impliquer la caducité des formalismes et donc des modélisations.

Production de données empiriques

Au-delà de l’inventaire des causes et de la stabilité de celles-ci, il existe des limites aux modélisations en sciences sociales liées à la production de données empiriques et à leur disponibilité – les données empiriques correspondent à des valeurs numériques associées à des catégories : nombre de personnes appartenant à une catégorie, mesure d’une variable quantitative. Je ne fais ici qu’égrener quelques limites couramment débattues en philosophie des sciences.

Préalablement à toute enquête ou expérimentation, un dispositif expérimental est conçu. Or comme le soulignaient Bourdieu, Passeron et Chamboredon dans Le métier de sociologue (1968), « Il n’est pas jusqu’aux opérations les plus élémentaires et, en apparence, les plus automatiques du traitement de l’information qui n’engagent des choix épistémologiques et même une théorie de l’objet. Il est trop évident par exemple que c’est toute une théorie, consciente ou inconsciente, de la stratification sociale qui est en jeu dans le codage des indicateurs de la position sociale ou dans le découpage des catégories34 […]. » On dit fréquemment que les concepts, notamment les catégories en sciences sociales, sont « chargés de théorie » (theory ladden). Cela vaut pour tout type d’enquête ou d’expérimentation, que celles-ci soient réalisées par des instituts nationaux et internationaux de statistiques ou par des équipes de recherche, universitaires ou privées.

En économétrie, une « limite de testabilité provient de la fréquente rareté des données aptes à valider le modèle. Certaines grandeurs observées font l’objet d’un recueil historique sur des séries très courtes ou résultent d’enquêtes exceptionnelles. D’autres grandeurs, bien que théoriquement observables, ne le sont que localement, en l’occurrence à l’équilibre. […] les expériences de laboratoire permettent théoriquement de compenser le manque de données historiques. Mais elles sont rarement répétées à l’identique, bien que leur duplication soit toujours invoquée comme indispensable35. »

En sociologie comme en économie, si les données ne sont pas disponibles, fournies en particulier par des instituts, il est possible de les produire en réalisant soi-même ou en sous-traitant la réalisation d’une enquête. Néanmoins, la construction de l’échantillon ne pouvant en général se faire sur tirage aléatoire, comme procède l’INSEE, le « risque d’erreur » dans l’estimation des distributions de la population d’origine n’est pas mesurable36. Le même type de problématique se retrouve avec l’exploitation d’enquêtes historiques.

Une autre limite « est imputable au caractère presque toujours non exhaustif des réponses obtenues dans les enquêtes par questionnaires comme lors du traitement de corpus historiques. Les taux de réponses dans les enquêtes par questionnaires sont souvent très inférieurs à ce qu’ils devraient être pour accorder aux résultats obtenus autre chose qu’une confiance provisoire37. » Signalons également la limite liée à l’attribution d’un individu particulier à une catégorie, la frontière entre deux catégories sociales n’étant pas toujours évidente.

Validation des modèles

Une fois les données empiriques récoltées, des traitements formels leur sont appliqués pour obtenir des résultats qui peuvent être comparés :

- à d’autres données empiriques, ultérieurement lorsqu’il s’agit de modèles prédictifs ;

- à d’autres résultats obtenus précédemment.

Ces comparaisons fournissent des éléments de validation externe38. Elles reposent en partie sur la possibilité de reproduire des expérimentations, qui dépend de la stabilité des paramètres théoriques et plus largement des causes entre deux expérimentations.

La validation interne concerne la méthodologie employée, notamment les aspects relatifs à la production des données empiriques ainsi qu’à l’application de traitements formels, que ceux-ci soient mathématiques ou algorithmiques. Dans le cas de modèles multi-agents, cette validation consiste plus spécialement « à s’interroger sur la conformité entre les spécifications et le programme implémenté39 ». Dans le cas des méthodes statistiques, de multiples problématiques relatives à la validation interne existent, parmi celles-ci : la construction de variables résultant d’une somme de données quantitatives ; l’emploi de certaines méthodes statistiques plutôt que d’autres ; la rigueur concernant la mise en œuvre d’une méthode statistique donnée40. Mentionnons enfin le vaste débat, concernant d’ailleurs en premier lieu la biologie, autour du seuil de signification d’un test d’hypothèse statistique41 : le test de Neyman-Pearson est-il fiable ? Peut-on rejeter une hypothèse s’il existe 5% de risque de s’être trompé ? Ne faudrait-il pas plutôt prendre un seuil de 1% ?

Les modèles en économie et en sociologie sont particulièrement délicats à valider parce qu’ils mobilisent des méthodologies et des formalismes complexes, parce qu’ils ne sont pas nécessairement adossés à une théorie représentant une forme de stabilité, mais aussi parce qu’ils se multiplient. En économie, selon Bernard Walliser, les « modèles connaissent une prolifération anarchique qui leur fait perdre de leur puissance et de leur originalité. La modélisation s’attaque à tous les domaines possibles et imaginables sans prendre en compte leur spécificité profonde42, » elle manifeste une « dérive laxiste ». Si les modèles foisonnent, n’est-ce pas entre autres en raison de l’absence de théories suffisamment stables et reconnues par la communauté scientifique ?

Dans leur ouvrage collectif de 1999, Models as Mediators, Mary Morgan et Margaret Morrison qualifient les modèles d’ « outils43 », d’objets « autonomes » par rapport aux théories et aux phénomènes étudiés. De ce point de vue, les formalismes peuvent être considérés comme des outils mathématiques, logiques ou algorithmiques, des techniques permettant d’obtenir des informations à propos de phénomènes. Mais si les modèles sont des techniques, quid de leur scientificité ? Peut-on qualifier de scientifique une modélisation dont les paramètres théoriques évoluent, entraînant l’inapplicabilité du formalisme, une modélisation dont les résultats ne peuvent être comparés que très approximativement avec des données empiriques ? Nous reviendrons dans de futurs articles sur la question la notion de scientificité.

Malgré ces dernières questions en suspens, il me semble qu’en ayant distingué les formalismes des paramètres théoriques et qu’en ayant distingué différents types de concept la notion de modèle en sciences apparaît moins confuse.

Annexe : de multiples fonctions

Le concept de modèle comprend de multiples facettes. Historiquement, il a été employé en premier lieu pour un usage prescriptif, puis il a évolué à partir du XVIIe siècle vers une vocation davantage descriptive en sciences.

Nous avons vu au travers de plusieurs exemples44 qu’il peut fournir une représentation de la réalité, qu’il peut avoir un intérêt heuristique, une visée instrumentale, ou qu’une famille de modèles peut définir la vérité suivant une conception sémantique des théories. Le philosophe des sciences Franck Varenne résume45 la diversité des fonctions scientifiques d’un modèle au travers de cinq grandes catégories suivantes :

- Faciliter une observation, une expérimentation.

- Faciliter une présentation intelligible « via représentation mentale figurée ou schématique ou même déjà via une conceptualisation et une interaction de concepts, un concept étant une idée générale bien définie et applicable à certains objets ou phénomènes réels ou réalisables. »

- Faciliter une théorisation.

- Faciliter la médiation entre discours, en particulier entre domaines d’étude.

- Faciliter la médiation entre représentation et action : prise de décision, notamment politique dans le cas d’une gestion d’épidémie, et dans le cas où le modèle est « auto-réalisateur ».

Ces grandes fonctions correspondent sensiblement à celles évoquées par Mary Morgan et Margaret Morrison dans leur ouvrage collectif46 de 1999, Models as Mediators, qui prend en compte la physique, la chimie et l’économie. Elles recoupent également en grande partie celles évoquées par Bernard Walliser47.

Notes

1.↑ Bernard Walliser, Comment raisonnent les économistes, Odile Jacob, 2011.

2.↑ Concernant cet aspect plus littéraire et conceptuel, voir notamment Jean-Michel Chapoulie, Enquête sur la connaissance du monde social, Anthropologie, histoire, sociologie, France-États-Unis 1950-2000, Presses Universitaires de Rennes, 2017, chapitre IV.

3.↑ Franck Varenne, « Histoire de la modélisation : quelques jalons », Actes du colloque Modélisation succès et limites, CNRS & Académie des technologies, Paris, 6 décembre 2016. URL : https://hal.archives-ouvertes.fr/hal-02495473/document

4.↑ On peut distinguer deux grands types de méthodes statistiques permettant de modéliser : la statistique exploratoire (méthodes factorielles, méthodes de classification) et les méthodes explicatives/prédictives. Voir l’introduction de Ludovic Lebart, Alain Morineau, Marie Piron, Statistique exploratoire multidimensionnelle, Paris, Dunod, 1995. Pour une étude plus poussée sur le plan mathématique : Gilbert Saporta, Probabilités, analyse des données et statistiques, Technip, 2006. Pour une approche économétrique : Régis Bourdonnais, Économétrie, Dunod, 2021.

5.↑ Franck Varenne, op. cit.

6.↑ Armatte Michel, Dahan Dalmedico Amy. Modèles et modélisations, 1950-2000 : Nouvelles pratiques, nouveaux enjeux in: Revue d’histoire des sciences, tome 57, n°2, 2004. pp. 243-303. DOI : https://doi.org/10.3406/rhs.2004.2214 ; www.persee.fr/doc/rhs_0151-4105_2004_num_57_2_2214.

7.↑ Source : Jean-Pierre FLORENS, « ÉCONOMÉTRIE », Encyclopædia Universalis [en ligne], consulté le 23 mai 2021. URL : https://www.universalis.fr/encyclopedie/econometrie/

8.↑ Pabjan, Barbara. “The use of models in sociology”. Physica A: Statistical Mechanics and its Applications, Volume 336, Issues 1–2, 2004, Pages 146-152, ISSN 0378-4371, https://doi.org/10.1016/j.physa.2004.01.019. Pour les auteurs : Raymond Boudon, L’inégalité des chances, Fayard, 2010, p. 36 sq.

9.↑ Pierre Bourdieu, La distinction, Paris, Les Éditions de Minuit, 2016.

10.↑ Cf. note 4.

11.↑ Raymond Boudon, op. cit.

12.↑ Quelques liens concernant les modèles multi-agents : Macy, Michael W. and Willer, Robert. “From Factors to Actors: Computational Sociology and Agent-Based Modeling”. In Annu. Rev. Sociol. 2002. 28:143–66. doi: 10.1146/annurev.soc.28.110601.141117 Frédéric Amblard, Juliette Rouchier, Pierre Bommel, Franck Varenne et Denis Phan dans « Evaluation et validation de modèles multi-agents ». In : Modélisation et simulation multi-agents : applications aux Sciences de l’Homme et de la Société. Amblard Frédéric, Phan Denis. Paris : Hermes Science Publications, 2006, p. 103-140. (Science informatique et SHS) ISBN 2-7462-1310-9. Bianchi, Federico and Squazzoni, Flaminio. “Agent-based models in sociology”. WIREs Comput Stat 2015, 7:284–306. doi: 10.1002/wics.1356

13.↑ Raymond Boudon, op. cit., p. 36.

14.↑ Ibid., p. 175.

15.↑ ibid., p. 190 : « On a vu que, même en éliminant complètement les inégalités culturelles, le modèle engendre des inégalités considérables devant l’enseignement. »

16.↑ Livet Pierre, Phan Denis, Sanders Lena, « Diversité et complémentarité des modèles multi-agents en sciences sociales », Revue française de sociologie, 2014/4 (Vol. 55), p. 689-729. DOI : 10.3917/rfs.554.0689. URL : https://www.cairn.info/revue-francaise-de-sociologie-2014-4-page-689.htm. Pour une précision et une illustration du modèle : https://www.gemass.fr/dphan/complexe/schellingfr.html

17.↑ À ce sujet, voir par exemple Hedström, Peter, and Peter Bearman, editors. The Oxford Handbook of Analytical Sociology, Oxford University Press, 2011, chapter 17.

18.↑ Granovetter, Mark. “Threshold Models of Collective Behavior”. American Journal of Sociology, vol. 83, n°6 (May 1978), The University of Chicago, p. 1420-1433.

19.↑ Pour une synthèse : Harold Kincaid, “Causation in the Social Sciences”. In BeeBee, H., Hitchcock, P., and Menzies, P. (Eds). The Oxford Handbook of Causation, Oxford University Press, 2009, chapter 36.

20.↑ Voir notamment Luc Boltanski, De la critique. Précis de sociologie de l’émancipation, Gallimard, 2009 ; Dominique Méda, La mystique de la croissance. Comment s’en libérer, Flammarion, 2013 ; Eva Illouz, Edgar Cabanas, Happycratie – Comment l’industrie du bonheur a pris le contrôle de nos vies, Premier Parallèle, 2018.

21.↑ Voir les deux notes précédentes.

22.↑ Par exemple, Mark Granovetter, sociologue de l’économie part d’une approche individualiste et s’efforce d’intégrer des éléments culturels.

23.↑ Max Weber, Essais sur la théorie de la science, Plon, 1965, p. 125-126. Je souligne.

24.↑ Voir par exemple le modèle de Robert Lucas, “Expectations and the Neutrality of Money”. Journal of Economic Theory, 4, 103-124 (1972), et le commentaire de Nancy Cartwright “The Vanity of Rigour in Economics: Theoretical Models and Galilean Experiments”. Hunting Causes and Using Them. Cambridge University Press, 2007. Voir également Bäckman, Olof, and Edling, Christofer. “Mathematics Matters: On the Absence of Mathematical Models in Quantitative Sociology”. Acta Sociologica, 1999, vol. 42, p. 69-78 : “each one of these assumptions can justly be contested, but the point we wish to stress here is that they are made explicit.”

25.↑ Mark Granovetter, Société et économie, Seuil, 2020. Lien vers l’article intéressant de McCloskey, « The Rhetoric of Economics ». Journal of Economic Literature, Volume 21, Issue 2 (Jun, 1983), 481-517. Cet article a donné lieu à un livre éponyme qui détaille la pensée de l’autrice (qui s’appelait encore Donald en 1983).

26.↑ Dans La question de la liberté et sur ce site Internet.

27.↑ Luc Boltanski, Laurent Thévenot, De la justification, Les économies de la grandeur, Gallimard, 1991, p. 24 : « Cette réflexion sur la symétrie entre les langages de description ou les principes explicatifs mis en œuvre par les sciences sociales et, d’autre part, les modes de justification ou de critique utilisés par les acteurs, nous a rendus particulièrement attentifs aux tensions qui habitent la sociologie lorsqu’elle prétend concilier une conception positiviste de la neutralité scientifique et une exigence de critique sociale. Car la sociologie critique se met alors dans l’impossibilité de ressaisir les dimensions nécessairement normatives qui soutiennent la contribution qu’elle apporte à la dénonciation des injustices sociales, ce qui la conduit nécessairement à insister de façon abusive sur l’extériorité de la science pour fonder la légitimité de sa pratique. »

28.↑ Bernard Walliser, op. cit. Je souligne.

29.↑ Nancy Cartwright, op. cit. (note 22)

30.↑ Ibid.

31.↑ Jean-Michel Chapoulie, Enquête sur la connaissance du monde social, Anthropologie, histoire, sociologie, France-États-Unis 1950-2000, Presses Universitaires de Rennes, 2017.

32.↑ Pour un inventaire des approches de la causalité en sciences : BeeBee, H., Hitchcock, P., and Menzies, P. (Eds). The Oxford Handbook of Causation, Oxford University Press, 2009.

33.↑ Voir notamment Bernard Walliser, op. cit.; Cartwright, Nancy. Hunting Causes and Using Them: Approaches in Philosophy and Economics. Cambridge University Press, 2007 ; Cartwright, Nancy. “RCTs, Evidence, and Predicting Policy Effectiveness”. In Kincaid, Harold, editor. The Oxford Handbook of Philosophy of Social Science. Oxford University Press, 2012, p. 298-318 ; Pearl, Judea and Mackenzie, Dana. The Book of Why. The New Science of Cause and Effect. Penguing Books, 2019.

34.↑ Pierre Bourdieu, Jean-Claude Chamboredon, Jean-Claude Passeron, Le métier de sociologue, La Haye, Mouton, 1983, p. 67.

35.↑ Bernard Walliser, op. cit.

36.↑ Jean-Michel Chapoulie, op. cit.

37.↑ Ibid.

38.↑ Je reprends ici la terminologie employée par Frédéric Amblard, Juliette Rouchier, Pierre Bommel, Franck Varenne et Denis Phan, op. cit.

39.↑ Ibid.

40.↑ Ibid. : « Les prétentions à la rigueur des démarches statistiques ne sont que rarement discutées par ceux qui n’utilisent pas cette démarche. Leur méfiance à l’égard de l’approche statistique est plus volontiers formulée dans les conversations privées ».

41.↑ Voir notamment : Romeijn, Jan-Willem, « Philosophy of Statistics », The Stanford Encyclopedia of Philosophy (Spring 2017 Edition), Edward N. Zalta (ed.), URL = https://plato.stanford.edu/archives/spr2017/entries/statistics/, Section 3. Harold Kincaid, “Causation in the Social Sciences”, op. cit. Capel Roland, Monod Denis, Müller Jean-Pierre. De l’usage perverti des tests inférentiels en sciences humaines. In: Genèses, 26, 1997. Représentations nationales et pouvoirs d’Etat. pp. 123-142; doi : https://doi.org/10.3406/genes.1997.1436

42.↑ Bernard Walliser, op. cit.

43.↑ Morgan, Mary S. and Morrison, Margaret (eds.) (1999). Models as Mediators: Perspectives on Natural and Social Science. Cambridge University Press, p. 11.

44.↑ Les aspects représentation de la réalité et intérêt heuristique ont été abordés ici, la visée instrumentale ici, et l’idée qu’une famille de modèles peut définir ce que l’on entend par vérité là.

45.↑ Franck Varenne, op. cit.

46.↑ Morgan, Mary S. and Morrison, Margaret, op. cit.

47.↑ Bernard Walliser,op. cit. L’auteur identifie les fonctions iconique, syllogistique, empirique, heuristique, praxéologique et rhétorique.