Après avoir évoqué les grands axes sémantiques du concept de modèle à l’aube du XXe siècle, nous allons aborder la période 1900-1980 que l’on peut scinder en deux sous-périodes de quarante ans chacune. Afin d’appréhender, dans un premier temps, pourquoi les modèles scientifiques ont été tenus en suspicion jusqu’à la Seconde Guerre mondiale, nous commencerons par un focus sur les notions de probabilité et de statistique que nous envisagerons d’un point de vue historique.

Dans un second temps, nous nous intéresserons à la conception sémantique des théories qui constitue une évolution sensible de la doctrine des Empiristes logiques, valorisant de façon spectaculaire la notion de modèle. Nous verrons la distinction entre deux approches de cette conception, l’une logique l’autre scientifique, puis nous terminerons par un aperçu historique du développement des modélisations en sciences au-delà des conceptions philosophiques axées sur la physique.

Des modèles subordonnés aux théories

La percée des statistiques au XIXe siècle

Dans The Taming of Chance (l’apprivoisement de la chance), le philosophe des sciences canadien Ian Hacking estime qu’au cours du XIXe siècle, « il est devenu possible de voir que le monde pouvait être régulier et néanmoins n’être pas soumis aux lois universelles de la nature. Un espace s’était dégagé pour la chance1. » Les régularités non soumises aux lois de la nature ont été observées en premier lieu sur le plan social, avec la mise en œuvre progressive de statistiques répertoriant les individus, leur statut familial, fiscal ou militaire, comptabilisant les naissances, les décès, les crimes et les délits, enregistrant les productions de biens matériels et les échanges commerciaux… Ces recensements ont contribué à l’évaluation de mesures politiques, juridiques, économiques, sanitaires ou médicales. Adossés à une théorie des probabilités, ils ont également participé à l’appréciation du caractère « normal » ou non des personnes : « Un nouveau type de loi est apparu, analogue aux lois de la nature, mais relatif aux gens. Ces nouvelles lois étaient exprimées en termes de probabilités. Elles véhiculaient les notions de normalité et de déviation par rapport à la norme2. »

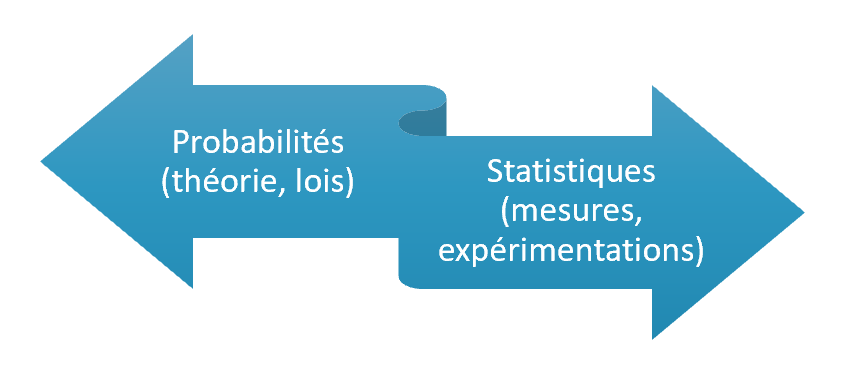

Distinguer les probabilités des statistiques s’avère périlleux, les deux mots étant fréquemment interchangeables. Sans essayer d’établir une délimitation entre les deux domaines, on peut estimer que le concept moderne de probabilité, apparu au sein de questionnements sur les jeux de hasard et sur la problématique de l’inférence3, relève davantage de la théorie, comportant notamment des lois déduites à partir d’axiomes, et que la notion de statistique, issue des comptabilités nationales, est plutôt associée historiquement à la mesure, à l’expérimentation, à leur traitement ainsi qu’à leur interprétation.

L’usage des statistiques s’est donc étendu pendant le XIXe siècle, d’abord sur le plan social, ensuite sur le plan scientifique en physique : Maxwell puis Boltzmann y ont eu recours pour formaliser le mouvement des particules élémentaires (atomes, molécules…) à l’état gazeux. Et l’on peut remarquer avec un certain étonnement que les deux scientifiques ont illustré la théorie cinétique des gaz via des analogies avec les statistiques sociales, notamment en ce qui concerne les régularités des crimes et des suicides4. Citons Boltzmann : « Buckle a démontré statistiquement que si un nombre suffisant de personnes est pris en compte, alors non seulement le nombre d’événements naturels tels que les décès, les maladies, etc. est parfaitement constant, mais le nombre des soi-disant actions volontaires l’est aussi – mariages à un âge donné, crimes et suicides. Cela ne se déroule pas autrement parmi les molécules5. »

L’affaiblissement du déterminisme

Que ce soit d’un point de vue social ou d’un point de vue physique, les réflexions sur les statistiques ont été associées à la question du déterminisme ainsi qu’à sa consœur philosophique, celle du libre arbitre. Les interprétations ont amplement divergé : tandis qu’Auguste Comte s’arc-boutait contre les probabilités qu’il percevait comme ennemies des lois scientifiques6, qu’Adolphe Quételet valorisait les aspects déterministes des lois de la « physique sociale » et réifiait les moyennes statistiques au travers du concept de l’ « homme moyen7 », Maxwell accordait une large place au hasard8.

Par opposition au déterminisme, la chance ou le hasard soulignent l’impossibilité :

- d’identifier de façon exhaustive les causes des phénomènes ;

- de prédire exactement l’évolution d’un système physique.

La formulation de lois statistiques correspond à un affaiblissement du déterminisme induit par la mécanique classique. Auguste Comte l’a très bien perçu et il s’y est opposé en promouvant le concept de loi scientifique. Même s’il rejetait les entités métaphysiques non formelles, il croyait que le calcul mathématique permettrait de prédire physiquement des situations aussi complexes que celles de l’évolution humaine. C’est ce qu’exprime sa loi des trois états (théologique, métaphysique, positif).

L’introduction des probabilités et des statistiques directement au cœur de la physique via la théorie cinétique des gaz a mis en évidence certaines limites quant à la capacité de prédiction offerte par les calculs mathématiques. Puis à la fin du XIXe siècle et au début du XXe siècle, plusieurs phénomènes n’ayant pu être interprétés à l’aune de la mécanique classique (chaleurs spécifiques des gaz, rayonnement du corps noir, expérience de Stern et Gerlach…) ont ouvert la voie de la mécanique quantique.

Alors que la mécanique classique permet de prédire de façon quasiment exacte, dans de multiples contextes, l’évolution temporelle d’un système physique en fonction des conditions initiales, les principes et les équations de la mécanique quantique permettent de déduire la probabilité qu’un système composé d’une ou plusieurs particules se trouve dans un état donné (lié à une position géographique, une énergie…) après la réalisation d’une mesure. L’avènement de la mécanique quantique a marqué la fin de l’hégémonie du déterminisme (nécessitarisme avant le XVIIIe siècle) sur le plan matériel, une hégémonie d’autant plus grande depuis le XVIIe siècle.

Discrédit des modèles scientifiques

On pourrait imaginer que l’expansion de l’emploi des statistiques en science, synonyme d’altération du déterminisme, ait favorisé l’utilisation des modèles. Il n’en est rien. L’impossibilité d’identifier exhaustivement les causes des phénomènes s’est remarquablement accordée avec le courant antimétaphysique de l’Empirisme logique qui a dominé la philosophie des sciences jusqu’à la fin de la Seconde Guerre mondiale. De plus, les formalismes mathématiques de la théorie de la relativité et de la mécanique quantique, très abstraits, se mariaient avec les vues d’un Pierre Duhem qui privilégiait la théorie abstraite par rapport aux modèles. On comprend mieux, dans ces circonstances, comment les modèles scientifiques ont été perçus avec méfiance pendant la première moitié du XXe siècle9.

Selon Hans Reichenbach, figure éminente de l’Empirisme logique, « Tout modèle ne possède jamais qu’une validité limitée, et rien n’est plus dangereux que la méconnaissance de ces limites ; car les caractéristiques du modèle ne permettent jamais de concevoir la nature autrement que selon un certain degré d’approximation, et en aucun cas dans toute sa généralité. Aujourd’hui, nous devons donc être également prêts à abandonner la dernière caractéristique que tous les modèles de la physique avaient jusqu’ici en commun : l’idée de déterminisme. Même la simple détermination d’un événement par un autre, qu’il s’agisse de boules dans l’espace ou de coïncidences spatiotemporelles, ne peut plus aujourd’hui être maintenue. Cette détermination n’était elle aussi qu’une idéalisation, utile à de nombreux égards; mais vouloir la postuler comme vérité dernière de la théorie de la connaissance reviendrait à étendre le modèle d’une manière tout à fait injustifiée10. »

Cet extrait met en relief la « validité limitée » du modèle, par opposition à la théorie dont la stabilité temporelle permet de justifier la vérité scientifique. Reichenbach est d’ailleurs celui qui a fameusement distingué contexte de découverte et contexte de justification. Le contexte de découverte souligne l’aspect psychologique et donc subjectif d’une nouvelle formulation lorsque le contexte de justification valorise l’objectivité d’une théorie, celle-ci ne dépendant donc ni de son auteur ni de la période historique qui l’a vu naître.

Carnap attribuait également un rôle mineur aux modèles : « Il est important de réaliser que la découverte d’un modèle n’a qu’une valeur esthétique, didactique ou au mieux heuristique, mais elle n’est pas du tout essentielle pour l’application réussie d’une théorie physique11. » Au long de la première moitié du XXe siècle, les modèles se sont ainsi retrouvés subordonnés aux théories en matière de vérité et d’explication.

Valorisation des modèles

La conception sémantique d’un point de vue logique

Au sein de l’Empirisme logique, la valorisation des théories par rapport aux modèles accompagnait une primauté du langage en philosophie des sciences qui a été surnommée « conception syntaxique ». Dès les années 1930, une autre conception qualifiée de « sémantique » a été amorcée sur un plan logique, notamment sous l’impulsion de Kurt Gödel et d’Alfred Tarski. Cette approche des théories distingue :

- Un langage théorique abstrait composé de symboles logiques (variables, connecteurs, constantes, fonctions, relations) à partir desquels sont élaborées des formules.

- Des structures définies sur un ensemble M, ou « univers », et correspondant à une interprétation du langage.

Par exemple, considérons le langage composé de la constante O et de la fonction S à un argument (unaire). On peut choisir les structures suivantes :

- La structure définie sur l’ensemble M des entiers naturels où OM(l’interprétation de O dans cette structure définie sur M) est le nombre zéro et SM est la fonction donnant le successeur : SM (n) = n+1 (le successeur de 1 est 2).

- La structure définie sur l’ensemble M des personnes où OM est « Toto » et SM est la fonction donnant le père d’une personne.

Dans ce cadre de pensée, une théorie correspond à un ensemble de formules ou d’énoncés12. Un modèle d’une théorie est une structure au sein de laquelle toute formule de la théorie est vraie. Le concept de vérité apparaît ainsi conjointement à celui de modèle qui est lié à un ensemble (de la théorie des ensembles). Si la vérité est associée au modèle, peut-on dire d’une théorie (tout court) qu’elle est vraie ? Elle peut être universellement vraie si elle l’est dans tout modèle, toute interprétation.

La conception sémantique d’un point de vue scientifique

La logique constitue un formalisme puissant, mais quand il s’agit de décrire les phénomènes physiques, elle a ses limites, ce que nous avons déjà souligné en abordant le courant de l’Empirisme logique. Ainsi elle peut être considérée comme une partie des mathématiques, mais l’inverse ne se vérifie pas. Or le recours aux mathématiques est systématique en sciences, depuis la physique jusqu’à la sociologie.

C’est ce que met en avant un courant philosophique qui a débuté dans les années 1960, notamment avec Patrick Suppes, et s’est poursuivi avec Bas van Fraassen dont l’essai The Scientific Image (1980) constitue une référence. Dans celui-ci, van Fraassen repart de l’approche logique évoquée ci-avant. Il écrit qu’en matière de vérité « Les modèles jouent le rôle principal13. » S’il estime que les modèles utilisés en sciences, par exemple celui de l’atome de Bohr, ne sont pas si éloignés de l’approche logique qu’on peut le dire, il reprend à son compte la maxime de Suppes : la « philosophie des sciences devrait utiliser les mathématiques, et pas les méta-mathématiques14 » (c’est-à-dire une forme de logique qui sous-tendrait les mathématiques).

Il cite l’exemple des postulats de la mécanique quantique, qu’il considère comme étant la description d’une famille de modèles, pour opposer :

- les théories sous forme « axiomatique » : les formules de la théorie se déduisent des axiomes et leur vérité dépend du modèle employé, autrement dit de l’interprétation des formules ;

- les théories dont la vérité repose, d’une part, sur une famille de modèles et, d’autre part, sur une adéquation empirique de ces modèles avec les apparences des phénomènes15, autrement dit avec les comptes rendus d’expérimentations et de mesures16.

Par exemple, le premier axiome de la mécanique quantique cité par van Fraassen est : « à chaque état pur correspond un vecteur, et à tous les états purs d’un système, un espace de Hilbert de vecteurs ». Pour donner une idée de la signification de cette phrase, un « état pur » est associé à une ou plusieurs caractéristiques physiques (position, vitesse, énergie…) d’un ensemble de particules élémentaires, appelé « système », que l’on souhaite « observer » ; un vecteur d’un espace de Hilbert est comparable à un vecteur (sous la forme géométrique d’une flèche) dans un espace euclidien classique. À chaque caractéristique ou ensemble de caractéristiques d’un système (par exemple la position) que l’on souhaite mesurer dans un contexte donné, correspond un modèle mathématique de mesure, c’est-à-dire une formule mathématique.

La conceptualisation théorique de van Fraassen est remarquable car elle questionne l’idée d’axiome. Selon lui, le terme d’axiome ne s’emploie rigoureusement que dans un cadre logique. Mais les axiomes de la logique s’appliquent à un langage qui est formellement distinct des ensembles, ainsi que je l’ai expliqué précédemment, donc de toute forme de réalité ! L’accent mis sur les modélisations et la relégation des axiomes fonde une approche antiréaliste des théories. Ces dernières se retrouvent, par un renversement sémantique, dépendantes des modèles qui, davantage en lien avec les phénomènes qu’avec les idées éthérées que sont les axiomes, deviennent les abstractions soutenant la vérité scientifique.

Le développement des modélisations en sciences

La conception sémantique des théories, si elle connaît deux tendances distinctes (logique vs. mathématique), trouve une unité dans la valorisation des modèles qui deviennent la pierre angulaire conceptuelle de la vérité scientifique. Elle s’est développée au sein d’un cadre de réflexion étroitement lié à la physique, les exemples de Suppes et de van Fraassen s’appuyant notamment sur la mécanique classique et la mécanique quantique.

Au-delà de l’Empirisme logique et de la conception sémantique des théories, axées sur la physique, la notion de modèle s’est déployée à partir des années 1930 dans les sciences de l’ingénieur et en sciences sociales17. Il s’agissait alors de modélisations qui s’émancipaient des analogies mécaniques (cf. article précédent) pour privilégier des « analogies directement mathématiques18 », et qui prenaient en compte des comportements non-linéaires, s’inspirant en particulier des travaux du physicien Balthazar Van der Pol.

Une innovation technique majeure, celle de l’ordinateur dont les premiers prototypes ont été développés durant la Seconde Guerre mondiale, a contribué également à l’expansion des modélisations. Le philosophe des sciences français Franck Varenne évoque un « tournant computationnel19 » qui a permis, d’une part, de simuler numériquement les modèles mathématiques et, d’autre part, de développer dès la fin des années 1940 « les approches Monte Carlo, c’est-à-dire des approches de formalisation et de résolution de modèle formel présentant deux aspects essentiels mais différents : une approche centrée sur les individus et sur leur comportement individuel (neutrons, cellules, atomes, molécules, etc.), doublée d’une approche recourant au hasard simulé (nombres pseudo-aléatoires) pour modéliser ce même comportement. »

Les modélisations se sont particulièrement développées en économie à la faveur de la Seconde Guerre mondiale et de la guerre froide « tant dans l’univers académique que dans les think tank de la recherche militaire, en recherche opérationnelle, théorie des jeux ou économétrie20 ». Cette recrudescence a engendré des questionnements sur la légitimité scientifique des modèles par rapport à la théorie et par rapport au but des Empiristes logiques ou d’un Karl Popper, très influent après-guerre, de parvenir à une conception unitaire de la science.

Ainsi, bien que l’emploi des modèles se soit répandu au cours de la seconde moitié du XXe siècle dans les conceptions philosophiques et les pratiques scientifiques, l’interrogation a persisté quant à leur légitimité en dehors d’un cadre théorique unificateur. Mais dans les sciences humaines, l’unité n’existait tout simplement pas en dehors de tentatives de synthèses ponctuelles21 qui ne parvenaient pas à rallier la majorité de la communauté scientifique. Dans ces domaines, les modélisations constituaient la seule formalisation possible permettant de structurer et de synthétiser un tant soit peu les connaissances. En physique, la conception sémantique des théories a mis au premier plan les modèles tout en conservant une préoccupation fondamentale pour l’unité théorique, même lorsque celle-ci passait par l’idée d’une « famille de modèles ».

Les quelques concepts et jalons égrenés dans cet article ne sauraient synthétiser une période aussi vaste et prolifique en sciences que celle s’étirant de 1900 à 1980. Ils m’apparaissent comme des clés de compréhension de la notion disparate de modèle. Dans les prochains articles, je m’intéresserai plus particulièrement au pragmatisme qui s’est imposé depuis les années 1980 comme un courant majeur en philosophie des sciences et qui, davantage encore que la conception sémantique des théories, valorise les modèles ainsi que les approches pluralistes des sciences.

Notes

1.↑ Ian Hacking, The Taming of Chance, Cambridge University Press, 2013.

2.↑ Ibid.

3.↑ Ian Hacking, The Emergence of Probability, Cambridge University Press, 2006.

4.↑ Zeno Swijtink, Lorenz Kruger, Theodore M. Porter, John Beatty, Lorraine Daston, Gerd Gigerenzer, The Empire of Chance: How Probability Changed Science and Everyday Life, Cambrige University Press, 1989, p. 61 sq.

5.↑ Ludwig Boltzmann, [1886] 1905. Der zweite Hauptsatz der mechanischen Wärmetheorie. In Boltzmann, 1905. Trans, as Boltzmann, [1886] 1974, p. 34. In Ibid. Je traduis de l’anglais.

6.↑ Auguste Comte, Système de politique positive, Tome I, Osnarbrück Otto Zeller, 1967, p. 469 : « l’absence de toute discipline philosophique a radicalement vicié la première base du vrai système de nos connaissances théoriques. L’irrationnelle consécration accordée au prétendu calcul des chances suffirait à caractériser, pour tous les bons esprits, les ravages scientifiques d’une telle anarchie mathématique. »

7.↑ Alain Desrosières, La politique des grands nombres, Histoire de la raison statistique, La Découverte, 2010.

8.↑ Ibid., p. 183.

9.↑Daniela M. Bailer Jones souligne la primauté de la théorie par rapport aux modèles durant la première moitié du XXe siècle dans Scientific Models in Philosophy of Science, University of Pittsburgh Press, 2009, chapitre 4.

10.↑ Hans Reichenbach, « Le concept de vérité en physique » in Christian Bonnet et Pierre Wagner (dir.), L’âge d’or de l’empirisme logique, Gallimard, 2006, p. 240. Je souligne.

11.↑ Carnap R., Foundations of logic and mathematics. In International Encyclopedia o f Unified Science. University of Chicago Press, 1939, p. 68. In Daniela M. Bailer Jones, op. cit. Je traduis.

12.↑ Plus exactement à un ensemble de formules closes, c’est-à-dire ne comprenant pas de variable libre. Voir par exemple pour une introduction au calcul des prédicats : http://pageperso.lif.univ-mrs.fr/~luigi.santocanale/teaching/1314teaching/LC/DOCS/cours5-8.pdf

13.↑ Bas van Fraassen, The Scientific Image, Clarendon Library of Logic and Philosophy. 1980. Clarendon Press. Édition du Kindle. Je traduis.

14.↑ Ibid. Je traduis.

15.↑ van Fraassen reprend ici volontairement le langage de Duhem.

16.↑ Pour être exact, selon van Fraassen, les apparences sont isomorphiques à des sous-structures des modèles. Pour l’objet du présent article qui est d’appréhender de façon globale le concept modèle, ces précisions sont superflues.

17.↑ Michel Armatte, Amy Dahan Dalmedico. Modèles et modélisations, 1950-2000 : Nouvelles pratiques, nouveaux enjeux in: Revue d’histoire des sciences, tome 57, n°2, 2004. pp. 243-303. DOI : https://doi.org/10.3406/rhs.2004.2214 ; www.persee.fr/doc/rhs_0151-4105_2004_num_57_2_2214.

18.↑ Ibid.

19.↑ Franck Varenne. Histoire de la modélisation : quelques jalons. « Modélisation, succès et limites », CNRS; Académie des Technologies, Dec 2016, Paris, France. ⟨hal-02495473⟩

20.↑ Michel Armatte, Amy Dahan Dalmedico, op. cit.

21.↑ Par exemple le structuro-fonctionnalisme de Talcott Parsons en sociologie.